Há poucos meses a NVIDIA trouxe ao mercado a GeForce GTX Titan X, a versão suprema e mais poderosa do novo chip Maxwell GM200. A novidade agora é a GTX 980 Ti, uma versão mais simplificada do mesmo chip, mas que oferece um ótimo desempenho e chega para ocupar o meio termo entre a GTX 980 e a Titan X.

A 980 Ti conta 6 GB de memória RAM — em uma única partição, segundo a empresa fez questão de deixar bem claro, para evitar a polêmica da GTX 970. Além disso, ela conta com 2.816 núcleos CUDA, contra 2.048 núcleos da GTX 980.

O chip é o mesmo da Titan X, com algumas diferenças básicas. Aqui, apenas 2 SMMs estão desativados, resultando em um número menor de núcleos CUDA. Porém a placa contém os mesmos 96 ROPs, 3 MB de cache L2 e o mesmo barramento de memória da Titan X.

Isso significa que a memória GDDR5 da placa roda com uma interface de 384-bit a 7 GHz. Isso resulta em uma banda de transferência 50% superior que de sua irmã menor, resultando, efetivamente, em 336,5 GB/s.

Além disso, ela também possui o mesmo TDP que a Titan X, ou seja, o GM200 tem um bom espaço para trabalhar sem que a energia seja um limitador para o desempenho da placa de vídeo.

Especificações

Em termos de design, a NVIDIA manteve o mesmo desenho de referência de suas placas de vídeo high end anteriores. Uma carcaça de alumínio cobre o dissipador e um blower que serve para refrigerar a câmara de vapor. Apesar de ser um desenho bonito e robusto, esse visual de referência já começa a ficar um pouco batido.

Contudo, em termos de eficiência, ele ainda é bem produzido. A placa mantém a temperatura estável e de maneira silenciosa, o que é sempre um ponto positivo. Em comparação com a Titan X, a principal diferença é a ausência dos chips de memória que ficavam na parte traseira da PCB. Essa novidade garante que a 980 Ti fique menos quente que sua irmã maior.

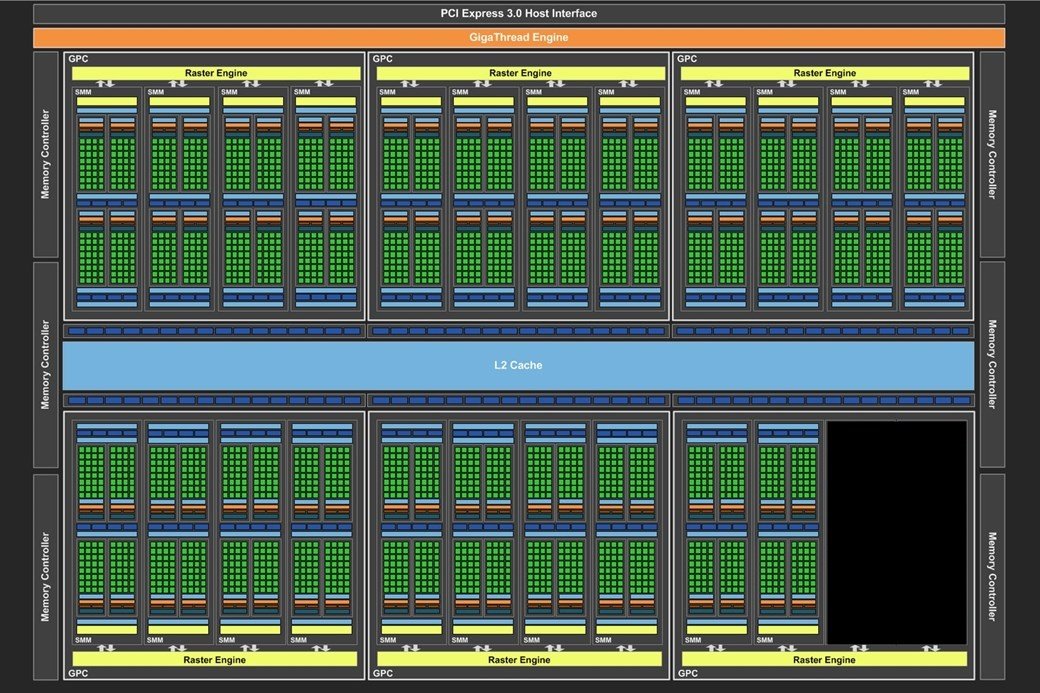

Arquitetura Maxwell GM200

A NVIDIA apresentou a arquitetura Maxwell no início do ano passado com a GTX 750 Ti. Depois dela chegou a GTX 980 trazendo o GM204 e todo o poder do Maxwell até então. Desta vez, as coisas mudam de figura e o nível aumenta ainda mais.

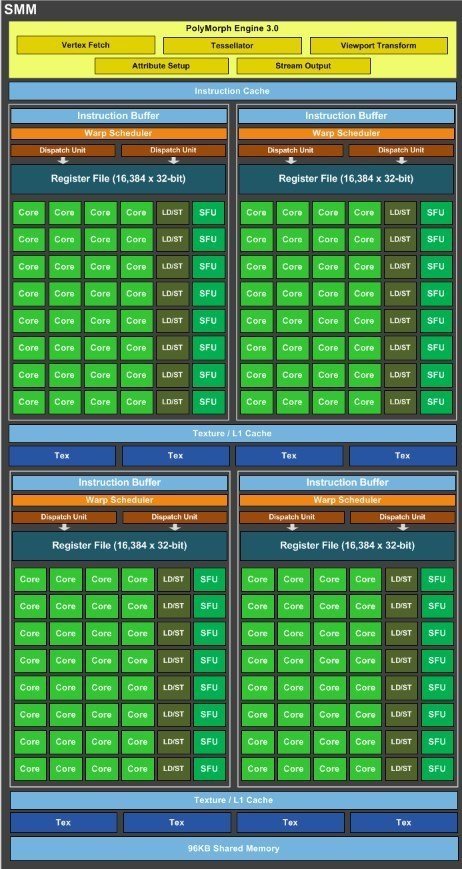

A GeForce GTX 980 Ti traz o GM200, uma nova GPU que é maior em que a anterior em quase todos os aspectos. O novo chip traz 3.072 núcleos CUDA divididos em 6 clusters de processamento gráfico e 22 unidades SMM (contra 24 da Titan X)

Um dos segredos da eficiência do Maxwell é o controlador de memória integrado a cada um dos SMM. Além disso, cada um dos clusters possui um rasterizador integrado, tornando o processamento dos dados mais eficiente.

A memória é dividida em seis controladores de memória de 64-bit. Com isso, os 6 GB de RAM rodam através de uma interface de 384-bit a um Clock de 7.010 MHz, o que resulta em uma banda efetiva de 336,5 GB por segundo. Como dito anteriormente, exatamente a mesma configuração da Titan X.

Outro ponto que colabora para a eficiência do Maxwell é a lógica de processamento das informações. O número de redundâncias internas na transferência dos dados diminuiu consideravelmente (em relação ao Kepler) e isso, consequentemente, também reduziu o consumo energético deixando tudo mais rápido.

Os pares de blocos de processamento agora compartilham quatro unidades de textura e cache de textura. O cache L1 também foi combinado com a função de cache de textura. A memória é dividida em sete unidades e é compartilhada entre os quatro blocos.

No Kepler (geração 600 e 700), um único controlador lógico era responsável por gerenciar e enviar instruções para blocos com 192 núcleos CUDA. No Maxwell, esse bloco foi dividido em quatro; desse modo, existem quatro conjuntos de 32 núcleos CUDA onde antes existia apenas um. Além disso, cada um deles possui o seu próprio controlador lógico.

Essa nova concepção garante que cada SMM seja significativamente menor, mesmo sendo capaz de entregar até 90% do desempenho de uma unidade SM presente na arquitetura Kepler. Essa área menor permite que mais SMMs sejam implementados dentro de uma única GPU. Isso garante 25% a mais de pico de textura, 1,7 vez mais núcleos CUDA e cerca de 2,3 vezes mais desempenho de shader.

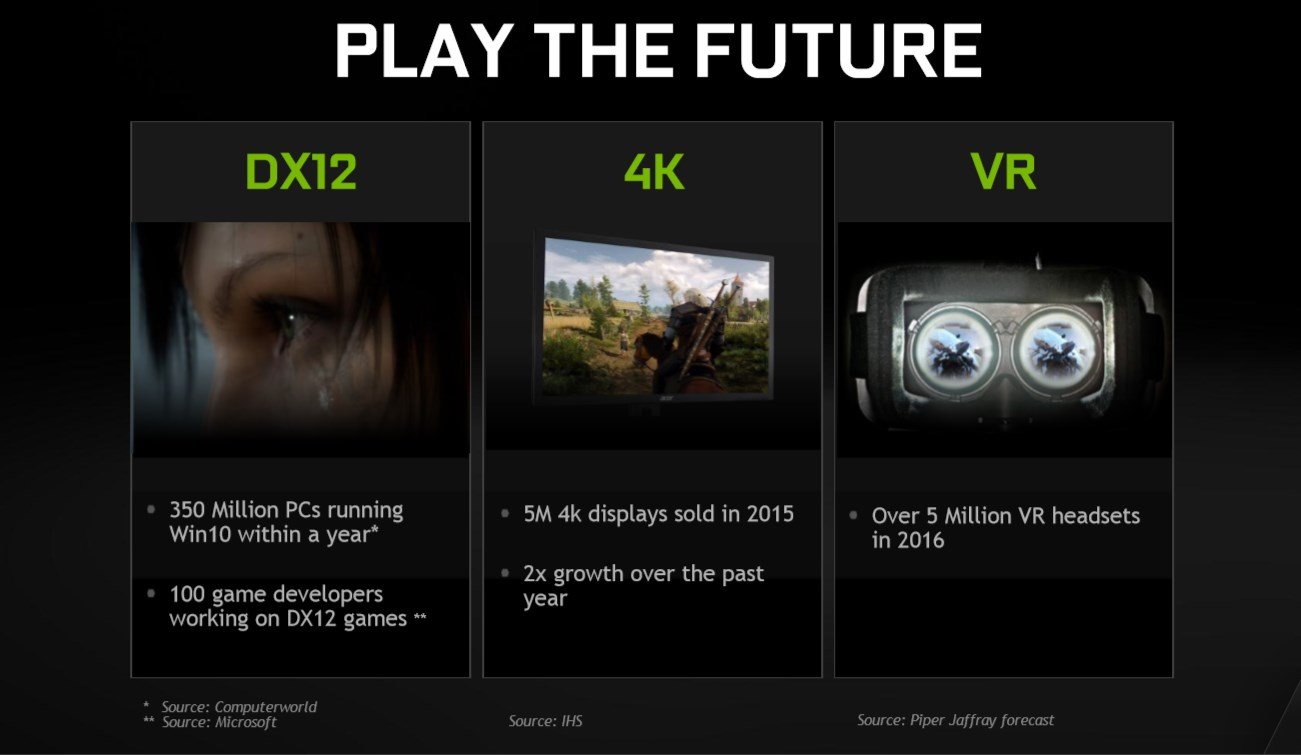

DirectX 12

A grande novidade dos games de PC para o final deste ano é o DirectX 12. A nova API gráfica da Microsoft promete um salto em termos de desempenho e aproveitamento dos recursos do sistema. E a GeForce GTX 980 Ti já conta com suporte total a essa tecnologia, mesmo que a API ainda não tenha sido oficialmente lançada.

Apesar de a maioria das GPUs modernas da NVIDIA já ser compatível com o DX12, a série GM200 conta com recursos do DX12.1, como o Volume Tiled Resources, que ajuda os desenvolvedores a criarem gráficos mais detalhados com um consumo muito menor de memória.

Efeitos como fluidos, fumaça e fogo agora podem ser desenvolvidos de forma mais eficiente que antes, consumindo muito menos recursos do sistema.

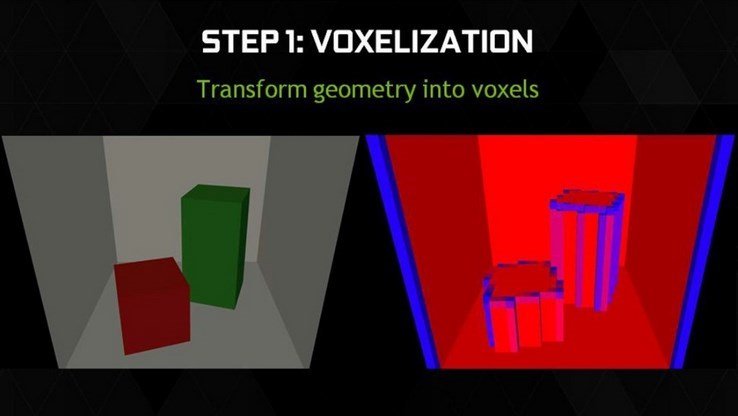

VXGI – Voxel Global Illumination

A iluminação é um dos recursos mais fundamentais na hora de garantir o realismo nas cenas. A NVIDIA sabe disso e lançou junto com a GTX 980 o VXGI, sigla para Voxel Global Illumination. A nova tecnologia pode aumentar a capacidade da GPU na hora de processar efeitos de iluminação global.

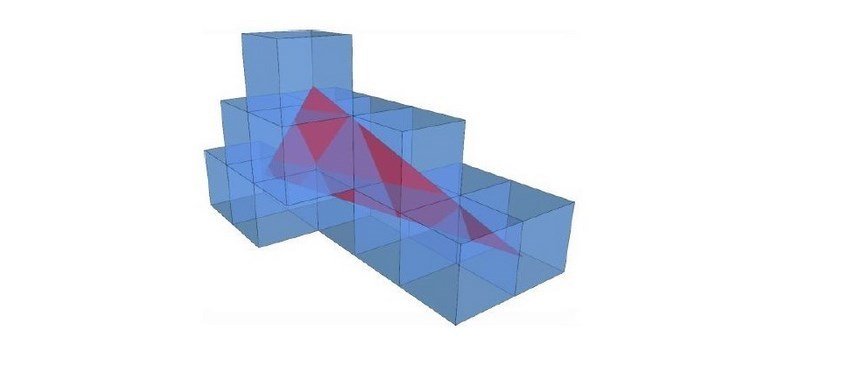

Para entender como o sistema trabalha, antes é preciso entender como os voxels funcionam: enquanto um pixel representa um ponto 2D no espaço, um voxel representa um pequeno cubo do espaço 3D. Para realizar a iluminação global, é preciso calcular a luz que é emitida por todos os objetos na cena, e não apenas as luzes diretas.

Para que isso seja feito, toda a cena é preenchida com pequenos cubos chamados voxels. Esse processo é chamado Voxelização, que é o ato de determinar o conteúdo da cena em cada voxel. Ele é análogo ao processo de rasterização, que é a determinação do valor de uma cena em dadas coordenadas 2D.

Veja na ilustração a seguir como esse processo acontece:

No VXGI, são armazenadas duas informações em cada voxel: a) a fração de voxel que contém um objeto real; e b) por qualquer voxel que contém um objeto, as propriedades da luz que vêm do objeto (ou seja, saltando para fora dele a partir das fontes de luz primária), incluindo direção e intensidade.

Assim que a fase de cobertura dos voxels termina, são armazenadas informações em cada voxel que descreve como a geometria física responde à luz. Isso inclui a codificação de opacidade da matéria e propriedades emissivas e reflexivas. Em seguida, a cena é checada novamente, desta vez verificando-se a iluminação direta em cada voxel não vazio. A cena é renderizada várias vezes a partir de pontos de vista de diferentes pontos de iluminação, capturando a luz que atinge cada voxel. O processo de voxelização fornece dados sobre toda a informação de luz presente na cena.

O último passo é a rasterização da cena, como ela é feita tradicionalmente. A diferença agora é que existe muito mais dados para serem utilizados nos cálculos juntamente com outras estruturas, como mapa de sombras.

De acordo com a NVIDIA, essa tecnologia pode ser escalonada para trabalhar em diferentes tipos de hardware, incluindo GPUs Kepler e até mesmo consoles de jogos. A vantagem do Maxwell é que ele já foi feito pensando nesse recurso, podendo aproveitar muito mais as novas funções.

O VXGI já está presente na Unreal Engine 4 e, em breve, deverá estar nos principais motores gráficos disponíveis no mercado.

DSR – Dynamic Super Resolution

A super-resolução dinâmica não é exatamente uma novidade. Existem diversas ferramentas não oficiais que podem fazer downsampling nas imagens, mas nada se iguala ao suporte oficial por parte do fabricante.

O que o DSR pode fazer é aumentar significativamente a qualidade das imagens. Para entender como ele funciona, pense em um monitor Full HD. Agora, imagine uma imagem em resolução inferior ao do monitor. Para preencher toda a tela, a imagem precisará ser esticada, deixando as imperfeições mais aparentes.

O downsampling funciona de forma parecida, só que ao contrário. Em vez de esticar uma imagem pequena para preencher a tela, ele espreme uma imagem grande para que ela possa ser exibida em um monitor com resolução menor à da imagem gerada, eliminando quase que completamente as imperfeições. Isso é especialmente útil para quem pretende rodar jogos com qualidade 4K em monitores Full HD.

Para completar, uma série de filtros especiais são aplicados às imagens com o objetivo de remover quaisquer possíveis serrilhados e/ou artefatos que restarem nas imagens. A Nokia usa um processo semelhante em alguns celulares que utilizam a tecnologia PureView, como o Lumia 930. Lá, as fotos são batidas com qualidade 20 MP e depois reduzidas para 5 MP, por exemplo.

A compatibilidade é garantida pelo GeForce Experience, que configura os jogos e todos os detalhes para que você não precise se preocupar com nada. Basta selecionar o game desejado e mudar a resolução.

Apesar de a NVIDIA focar o seu marketing no 4K, é possível utilizar resoluções menores, como o 2K ou outros valores compatíveis com a sua tela, pois o sistema oferece opções diferentes de configuração para que você possa encontrar o perfeito equilíbrio entre desempenho e qualidade visual. E isso é bastante importante, pois rodar jogos nessas resoluções exige muito do hardware.

Multi Sampling Anti-aliasing

O MSAA ou Multi Sampling Anti-aliasing é o método antisserrilhados mais comum hoje em dia. Essa técnica oferece um ótimo resultado visual, mas pode pesar um pouco em resoluções mais altas — principalmente em um hardware menos potente.

Para tentar resolver um pouco essa situação, a NVIDIA está trazendo o MFAA, que pode oferecer a mesma qualidade visual do MSAA, mas não pesa tanto na hora do processamento. Para fazer isso, o sistema aplica dois tipos diferentes de AA na imagem. Em seguida, as duas mescladas para garantir um efeito próximo ao do MSAA, mas com uma penalidade menor no desempenho.

PhysX e o utros recursos NVIDIA

Essa placa de vídeo também possui todos os recursos exclusivos desenvolvidos pela NVIDIA. Entre eles está o PhysX, um sistema que realiza os cálculos de física para trazer aos jogos efeitos mais realistas. Roupas, partículas e iluminação podem ficar muito mais detalhadas com o PhysX ativado.

Uma das novidades apresentadas pela empresa durante a GDC 2015 é que a partir de agora o código fonte do PhysX foi liberado para os desenvolvedores que quiserem implementar a versão acelerada por CPU do PhysX 3.3.3 em seus sistemas. Isso vai ampliar o desenvolvimento do sistema e permitir que mais motores gráficos tragam suporte ao PhysX.

Além do PhysX temos outros recursos avançados de antialiasing como o FXAA e o TXAA, capazes de garantir uma ótima qualidade visual sem comprometer muito o desempenho do sistema como um todo. O Adaptive V-Sync sincroniza as imagens com a frequência da tela para garantir a fluidez nas animações sempre que a placa tem poder de sobra. O efeito é ativado e desativado em tempo real para garantir um bom equilíbrio entre desempenho e qualidade visual.

NVIDIA G-Sync

O G-Sync foi apresentado há pouco tempo pela NVIDIA. Essa nova tecnologia pretende substituir o antigo V-Sync e acabar de uma vez por todas com o screen tearing e o input lag, problemas visuais que atrapalham na hora da diversão.

O novo recurso funciona forma inteligente: com o G-Sync ativado, todas as imagens são exibidas na tela no momento em que elas são renderizadas pela GPU, resultando em animações muito mais fluentes.

O que acontece hoje em dia é assim: a placa de vídeo processa as imagens e envia para o monitor, que exibe os quadros em taxas fixas (de 60 Hz, por exemplo). A GPU trabalha com taxas variáveis de renderização, pois vez ou outra os games podem apresentar cenas mais complexas. Essa diferença de tempo é o que causa os problemas.

A proposta do G-Sync é aproximar a taxa de renderização da GPU e do monitor, eliminando completamente os problemas de exibição de imagem. Quem já testou afirma que é difícil voltar para o modelo anterior, tamanho é o benefício proporcionado pela nova tecnologia.

Vale lembrar que para que o G-Sync possa ser utilizado, é preciso ter um monitor compatível, já que o hardware compatível com o sistema precisa estar integrado no próprio monitor.

Realidade virtual na GeForce GTX

A realidade virtual não é mais um sonho e está cada dia mais perto do nosso dia a dia. Inúmeras empresas já embarcaram no setor desenvolvendo alternativas viáveis para os jogadores, lideradas pela Oculus VR que deve trazer para o mercado a versão comercial do Rift ainda este ano.

Para ajudar a melhorar as experiências com a realidade virtual, a NVIDIA está trabalhando ao lado dos fabricantes para diminuir alguns problemas, como a latência das imagens exibidas na tela. Esse fator está ligado diretamente ao motion sickness que é um dos principais problemas da realidade virtual atualmente.

Para melhorar esse cenário, a NVIDIA traz o VR Direct, que oferece o recurso Asynchronous Time Warp. Nesse sistema, a última cena renderizada pela GPU é alterada com base na informação mais recente da posição da cabeça a partir do sensor VR.

Isso economiza tempo (e diminui a latência) já que a GPU não precisa recriar toda a cena do zero. A NVIDIA oferece suporte a nível de driver para definir a prioridade do contexto, permitindo que os desenvolvedores implementem o recurso em seus games e aplicativos.

Outro problema que pode afetar o desempenho em aplicações de realidade virtual é o desempenho. Se houver queda na taxa de quadros, a experiência pode ser perdida. Para minimizar esse problema a NVIDIA implementou um recurso chamado VR SLI. Isso significa que em um PC com duas GTX 980 Ti em SLI, cada uma das placas de vídeo pode ser designada para gerenciar a imagem enviada para um dos olhos, diminuindo latência e garantindo uma experiência mais rica.

Gameworks VR

Outra iniciativa importante da NVIDIA é o Gameworks VR. A iniciativa tem por objetivo unir software e hardware de forma mais completa, trazendo resultados ainda melhores para o mundo da realidade virtual nos jogos.

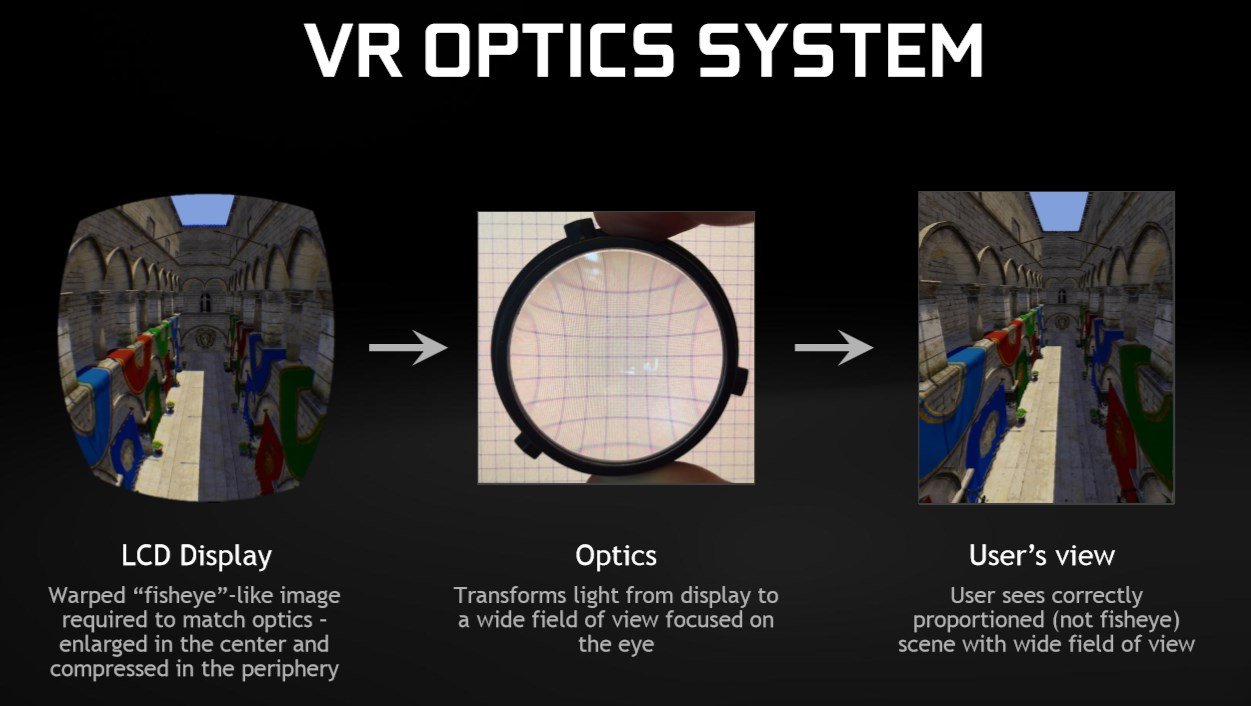

Os desenvolvedores que quiserem trabalhar com o sistema podem entrar em contato com a NVIDIA para receber as ferramentas necessárias para a criação desses conteúdos que oferecem recursos interessantes como o NVIDIA Multi-res Shading, uma técnica que renderiza as imagens já no formato fisheye utilizado pelos óculos de realidade virtual em vez de simplesmente renderizar a imagem em 2D e depois converter, o que acaba desperdiçando recursos importantes do sistema.

Segundo a empresa, essa técnica pode melhorar a eficiência de pixel shader em até 2x em relação as técnicas tradicionais.

Quanto vai custar?

A NVIDIA ainda não liberou o preço oficial da GeForce GTX 980 Ti no Brasil. Além disso, já podemos esperar por uma série de modelos e variantes fabricadas por empresas como ASUS, EVGA, Gigabyte e MSI, cada uma com recursos próprios de refrigeração e sistemas de controle de overclock característicos — o que também resultará em uma grande variedade de preços.

O preço de tabela para os Estados Unidos é de US$ 649 (cerca de R$ 2.062, sem impostos). Com isso, ela fica entre a Titan X (US$ 999) e a GTX 980 (US$ 499). Em termos de investimento x desempenho, ela passa a ser uma alternativa mais interessante que a Titan X para o consumidor médio que procura um melhor custo x benefício, principalmente para quem pretende montar um SLI com duas ou mais GTX 980 Ti.

Testes de desempenho

Como os testes são feitos

Todos os produtos testados no TecMundo são mantidos em suas configurações originais, ou seja, com os padrões de fábrica. Algumas placas de vídeo possuem chaves físicas e, ou configurações especiais para aumentar o desempenho, mas sempre que utilizamos esses recursos, identificamos nos testes.

No caso das placas de vídeo com arquitetura Maxwell em que a alteração do Power Limit pode trazer um razoável ganho de desempenho, esse recurso não é alterado durante os testes a não ser em condições especiais e, ou, se o fabricante já enviar o produto com esse parâmetro alterado.

Os drivers utilizados durante os testes sempre são a última versão estável disponível. A única alteração feita é a desativação do V-Sync para não limitar a taxa de quadros por segundo.

Máquina de testes

- CPU: Intel Core i7-3930K @ 3.800 MHz;

- Placa-mãe: EVGA X79 SLI;

- Memória: 16 GB RAM quad-channel G. Skill Sniper DDR3 2133;

- SSD: Kingston HyperX 3K 480 GB;

- HD: 3 TB Seagate ST3000M001;

- Fonte: Corsair AX1500i.

Jogos

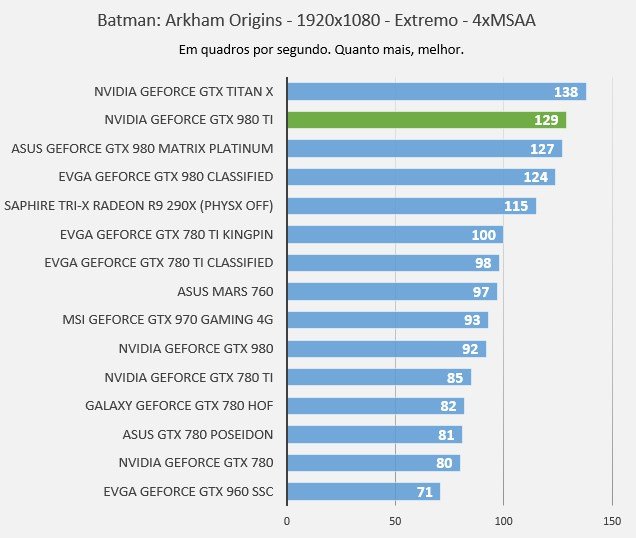

Batman: Arkham Origins

Batman: Arkham Origins utiliza uma versão modificada da Unreal Engine 3 e DirectX 11 aliados a diversos efeitos especiais para garantir o visual. O game também aproveita o PhysX da NVIDIA para trazer recursos de física mais realistas.

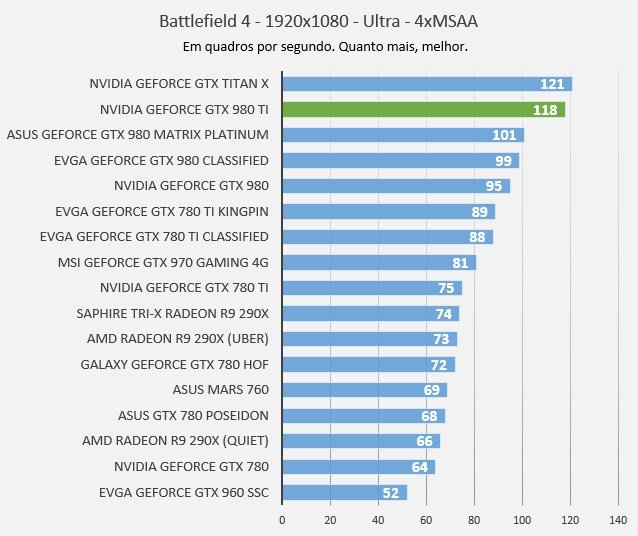

Battlefield 4

Battlefield 4 utiliza a nova engine Frostbite 3 para trazer efeitos especiais e ambientes maiores e mais detalhados, incluindo muitas partículas, texturas de alta resolução e tessellation. Tudo isso através do DirectX 11.

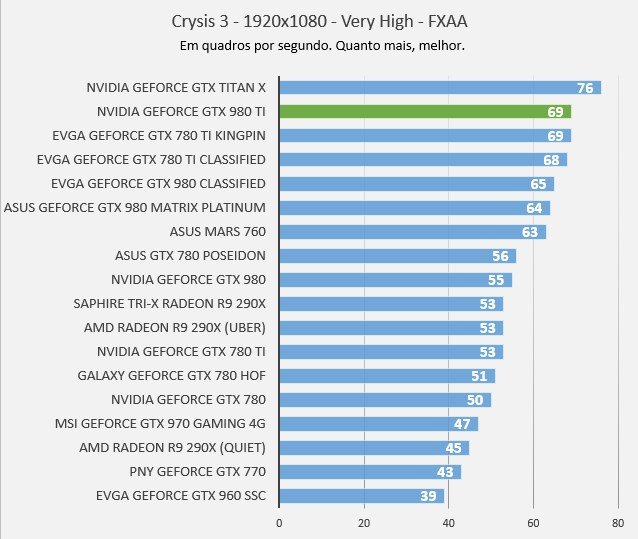

Crysis 3

O motor de Crysis 3 é o CryEngine 3, que desta vez apresenta uma série de novos recursos gráficos, incluindo fumaça e luz volumétricas e vegetação e tecidos dinâmicos, além de texturas em altíssima resolução. Para que tudo isso seja possível, o game roda exclusivamente com o DirectX 11.

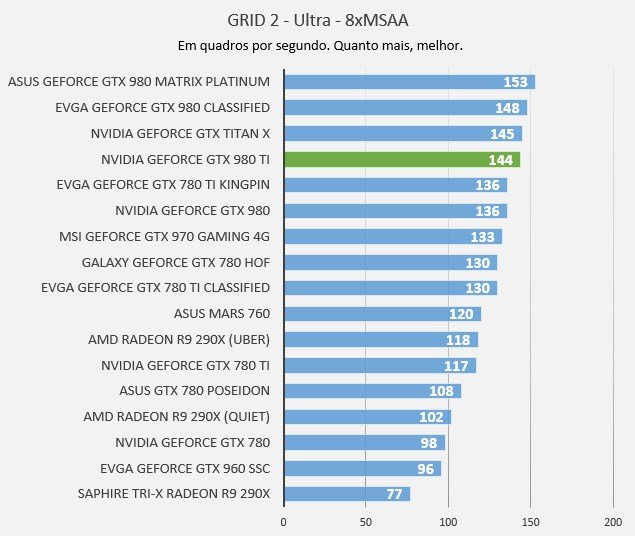

GRID 2

GRID 2 utiliza a engine EGO 3.0, desenvolvida pela Codemasters e presente em diversos games de corrida da desenvolvedora. O jogo apresenta efeitos visuais impressionantes, incluindo batidas, efeitos de fumaça, luz e sombras.

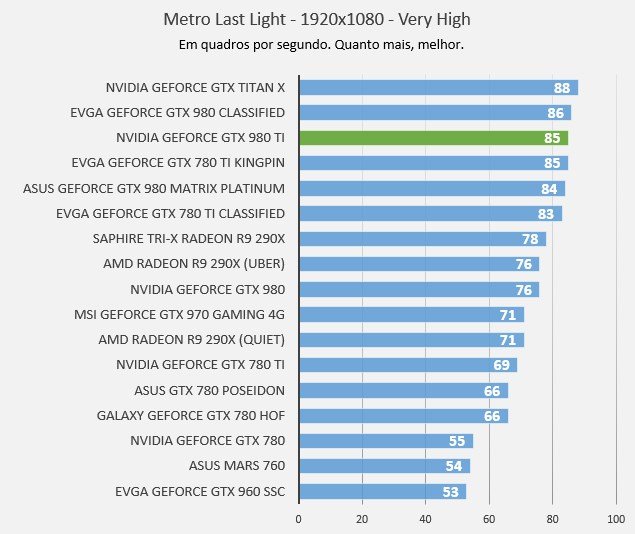

Metro: Last Light

Metro: Last Light aproveita o poder das GPUs modernas para trazer gráficos excelentes, texturas em alta definição e muita destruição com efeitos especiais incríveis. O game é construído com a engine 4A e também é compatível com o PhysX, da NVIDIA.

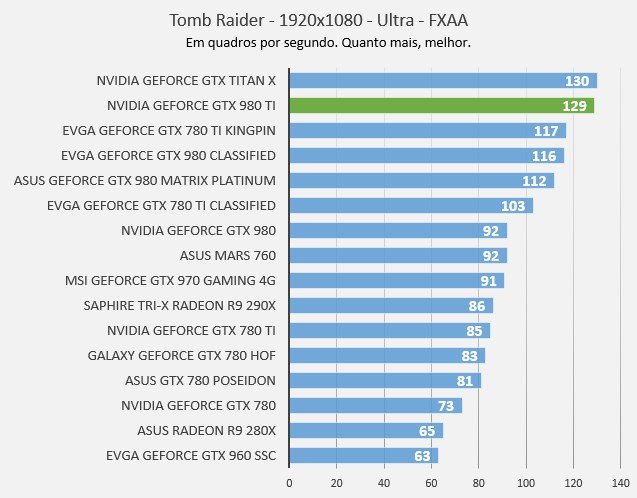

Tomb Raider

O reboot chegou com diversas novidades em relação aos games anteriores da série. O mundo aberto possui muitos lugares para serem explorados, e o título trabalha com texturas em alta definição e o recurso TressFX, que garante à protagonista do jogo cabelos incrivelmente detalhados.

Sintéticos

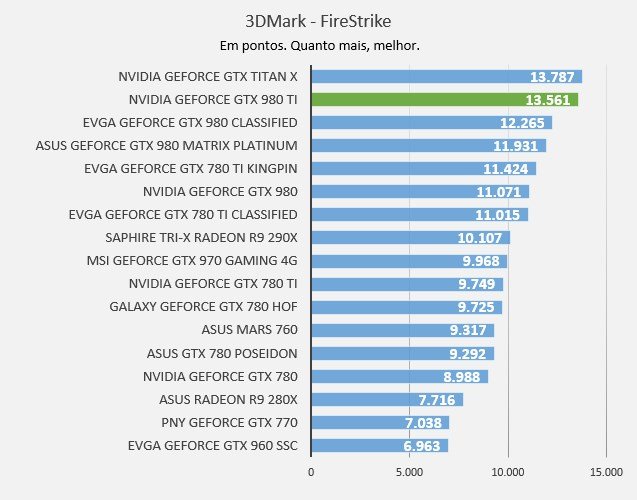

3DMark

O 3D Mark é, talvez, o mais conhecido software de benchmark do mercado. No mundo todo, pessoas utilizam essa ferramenta para medir o desempenho de suas máquinas. A versão que usamos é dividida em três categorias, e cada uma delas apresenta um nível de complexidade diferente.

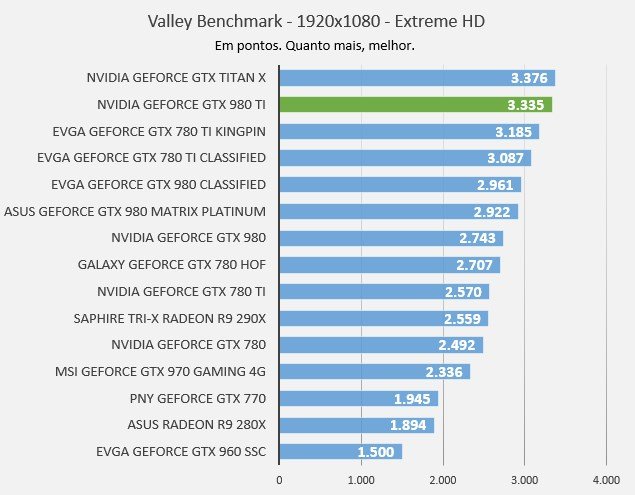

Valley Benchmark

O Valley Benchmark utiliza a Unigine para testar os limites do hardware. O software mostra uma região montanhosa com uma enorme quantidade de árvores e plantas de variadas espécies em um terreno de 64 milhões de metros quadrados. O Valley também exibe efeitos de luz e variações climáticas, colocando o poder das placas de vídeo à prova.

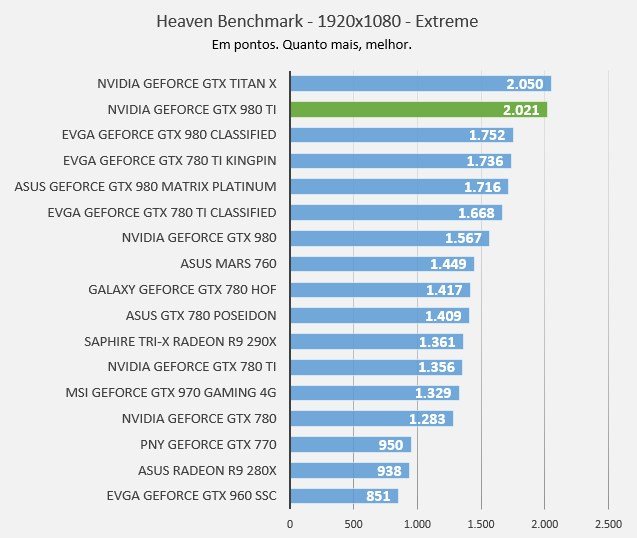

Heaven Benchmark

O Heaven Benchmark foi desenvolvido para explorar todos os recursos das placas de vídeo, testando os limites do hardware em situações específicas. O teste é baseado no motor gráfico Unigine e utiliza o que há de mais moderno em sistema de iluminação, física e tessellation para determinar o poder da placa de vídeo.

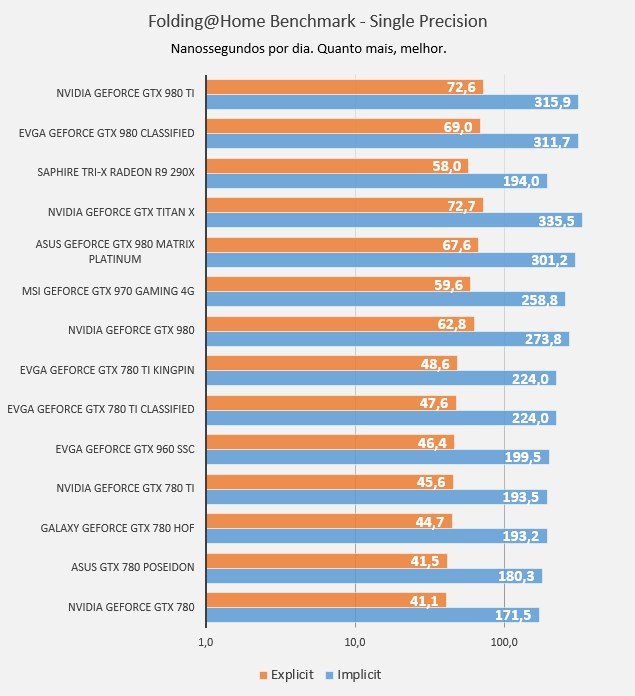

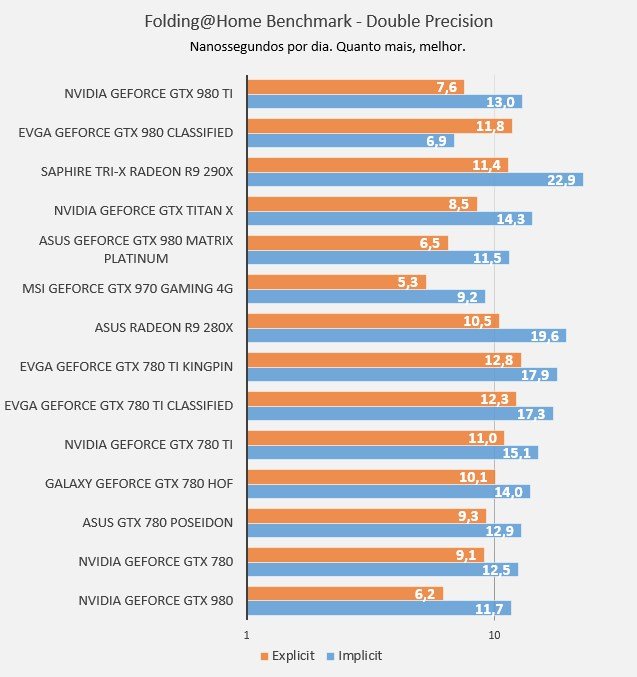

Folding @ Home

O FAHBench é um benchmark que simula os cálculos do Folding @ Home, a iniciativa de pesquisa em conjunto via internet que tem o objetivo de auxiliar na descoberta de cura para doenças como Alzheimer e Parkinson. O aplicativo utiliza o OpenCL para calcular os dados.

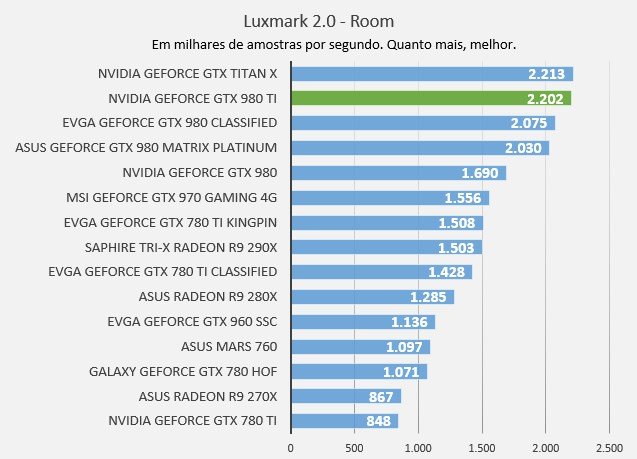

Luxmark 2.0

O Luxmark pertence à suíte gráfica LuxRender. O que esse teste faz é simular uma série de efeitos de ray tracing através da linguagem OpenCL.

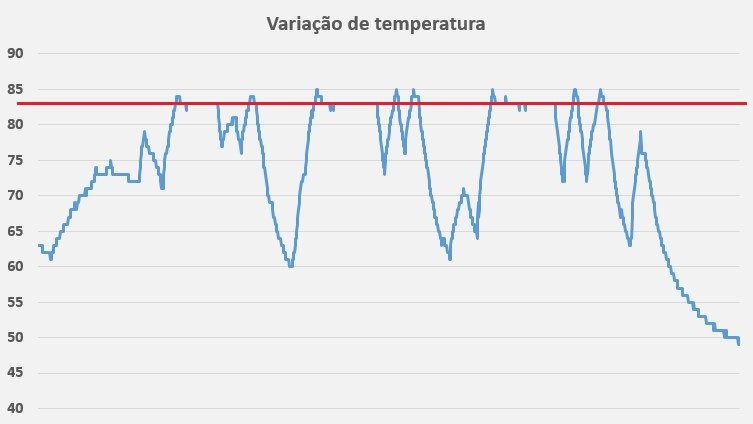

Temperatura e overclocks

A imagem térmica da placa de vídeo é capturada com a ajuda de uma câmera térmica FLIR modelo E6. Pelas imagens podemos ver com clareza quais os pontos que mais aquecem nessa placa de vídeo. Na parte frontal, os dois coolers conseguem dar conta do recado sem muitos problemas. Já atrás da placa, a região dos controladores de energia é a área que apresenta maior concentração de calor. A temperatura interna é monitorada com a ajuda do software GPU-Z, que registra todas as mudanças internas dos componentes.

Como já citando anteriormente, a placa consegue se manter a uma temperatura bem estável, ultrapassando o limite térmico poucas vezes durante uso mais intenso da GPU. Isso significa que em poucos momentos a placa precisou acelerar o giro da ventoinha para manter o processador mais frio.

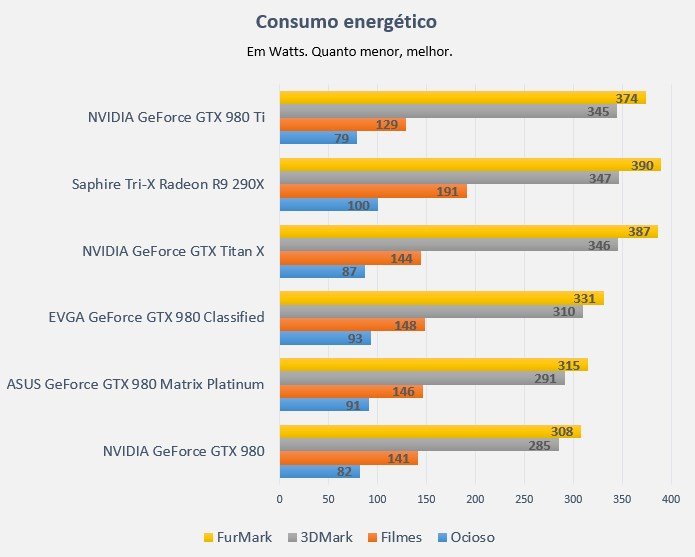

Consumo energético

Durante os testes, também realizamos algumas medições no consumo de energia com a ajuda de um dispositivo chamado Kill a Watt, que mede o consumo total da máquina, ou seja, quanto ela está “puxando” da tomada. As medições são realizadas em quatro momentos distintos:

- Ocioso: máquina ligada, mas sem nenhum aplicativo em atividade;

- Filme: filme em qualidade Full HD rodando em tela cheia;

- 3DMark FireStrike Extreme: simula o uso normal da máquina em jogos;

- FurMark: consumo extremo de energia, acima dos padrões normais.

Vale a pena?

Quem busca uma placa de vídeo top de linha vai encontrar na GTX 980 Ti tudo o que procura. Ela custa menos que a GeForce GTX Titan X e apresenta um desempenho similar. A principal diferença é a quantidade de memória. Porém, os 6 GB de RAM a menos da 980 Ti não deverão fazer muita diferença para a maioria das aplicações, já que os 6 GB restantes devem ser mais que suficientes para dar conta do recado.

Em termos de desempenho, ela não perde muito para a Titan X e mostra que o chip mais potente da arquitetura Maxwell realmente possui poder de fogo para brigar com as novas placas da AMD, lançadas recentemente.

Além do mais, a NVIDIA incluiu uma série de itens e recursos inovadores para garantir mais que frames por segundo. Um deles é o DirectX 12.1, que aliado às novas ferramentas de realidade virtual da placa farão ela aguentar um bom tempo na sua máquina de jogos.

A GeForce GTX 980 Ti está longe de ser uma placa de vídeo barata, mas se comparada com a Titan X, ela se mostra uma incrível alternativa para quem busca o mais alto desempenho nos games.

Agradecemos ao pessoal do Adrenaline por nos ter cedido a GeForce GTX 980 Ti para a análise.

Categorias

![Imagem de: Review: Testamos a placa de vídeo GeForce GTX 980 Ti [vídeo]](https://tm.ibxk.com.br/2015/07/13/13125305057006.jpg?ims=1280x480)