É impossível não pensar na utilização de robôs em guerras. Desde os anos 80, temos conteúdos midiáticos de todos os tipos, que nos bombardeiam com universos fictícios em que as máquinas assumem o controle e derrubam a humanidade ou lutam os nossos conflitos por nós. Desde o T- 800, de “Exterminador do Futuro”, ao HAL 9000, de “2001 – Uma Odisseia no Espaço”, temos um coletivo imaginário que cria um futuro com sistemas de computador autônomos que podem ser malignos. Em 1942, Isaac Asimov já preestabelecia, mesmo que em contos, as leis da robótica.

Contudo, era muito mais fácil fantasiar algo distante e surrealista. O desafio atual agora é outro, pois a tecnologia tão bem descrita por inúmeras obras literárias das últimas décadas é, agora, palpável. Com tamanha responsabilidade e risco, o que deve ser feito quando, atualmente, cerca de 40 países já trabalham em aparatos similares à ficção?

Desde de quinta-feira, está acontecendo o World Economic Forum (Fórum Mundial de Economia), em Davos, na Suíça. Porém, o que isso tem de comum com os robôs? Um dos tópicos debatidos por experts na área de inteligência artificial foi justamente o que fazer (ou não) com a possibilidade de existirem máquinas autônomas capazes de matar outros seres humanos. Montamos este pequeno artigo para que você entenda a discussão.

Questões éticas, morais e as leis da guerra

Por extensão de um padrão que se segue por centenas ou milhares de anos, cada vez mais o confronto militar está longe dos combatentes. De escudos e espadas, os soldados passaram a usar baionetas e rifles de um único tiro; disso, vieram as armas modernas e batalhas distanciadas. Hoje, temos sistemas de ataques avançados, drones de reconhecimento e, quem sabe, no futuro, sistemas autônomos.

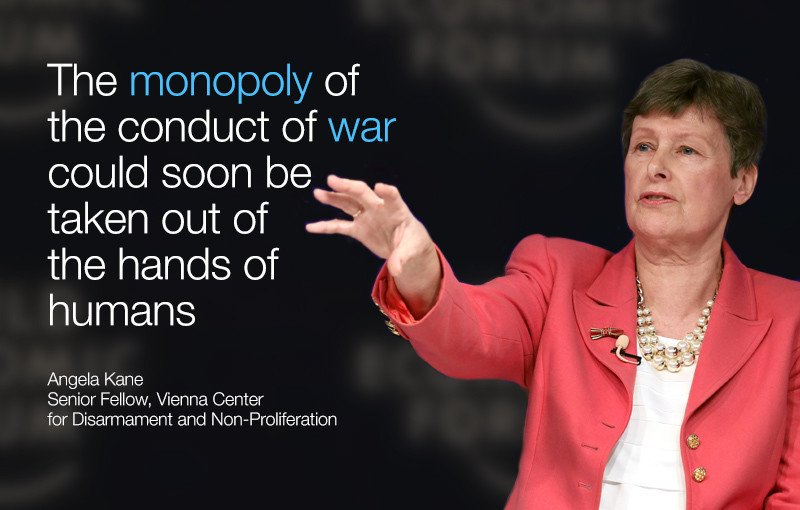

Felizmente, de acordo com um consenso geral, esse talvez não seja o caso. A questão é que se a guerra for terceirizada para robôs com autonomia, os países deixarão de ser arquitetos da destruição e assumirão o papel de telespectadores de um confronto independente de política, ética ou moral.

Stop the Killer Robots from Kamille Rodriguez on Vimeo.

A partir daí, surge a outra pergunta: como fazer uma inteligência artificial entender o que é aceitável ou não? As leis da guerra, por exemplo, proíbem que paraquedistas sejam abatidos após abandonarem o avião. Como ensinar uma máquina sobre o que é certo e errado, quando esse conceito já não é claro para soldados comuns? Retirar o fardo humano da fórmula seria errado, segundo os pesquisadores da área. Em caso de erros, não haveria quem culpar ou responsabilizar.

Os diversos níveis de robótica e a utilização atual

Quando pensamos em guerras futurísticas com robôs, logo imaginamos o final de “O Exterminador do Futuro”, com centenas de máquinas com formato humanoide marchando para algum lugar. Bom, acontece é que não é bem assim, pois o segmento militar preza por itens rápidos, pequenos e difíceis de serem localizados, coisa que já vemos na atualidade.

Segundo o presidente da BAE Systems Pic, Sir Roger Carr, a versão autônoma de armas é um cenário extremo. Precedente a ele, há mais duas camadas: uma delas é a mais rotineira, como controlar drones e outros aparatos que dependem diretamente de seres humanos; já a segunda envolve armamentos com algum tipo de sistema automático, que pode tomar decisões pequenas.

Alguns especialistas defendem que um armamento realmente independente é algo mal visto por governos e empresas no momento, e pode demorar quase uma centena de anos para ser desenvolvida. Contudo, com o avanço rápido e desenfreado, essa informação pode estar errada e a previsão não se concretizar.

Para evitar problemas, é necessária uma regulamentação

Ao longo do século passado, muitos termos foram discutidos, legislados e controlados, principalmente após o fim da Segunda Guerra Mundial. Esse foi o caso de diversos armamentos, como bombas nucleares, de fragmentação, napalm, armas químicas e muitas outras. Entretanto, ainda não há qualquer tipo de regulamentação para equipamentos autônomos.

Há grande questão é que armas de destruição em massa, que são vetadas pelo conselho internacional, estão nas mãos de alguns poucos países. Além disso, produzir armas nucleares é algo difícil de se conseguir, mesmo para Estados com recursos para isso, algo que muda completamente quando o assunto é tecnologia militar.

Atualmente, drones são relativamente acessíveis, e sistemas autônomos de direção podem logo entrarem no mesmo rumo. Da mesma forma, impressoras 3D para imprimir armas já algo real, que só depende de pessoas que saibam programar. O custo de entrada deste tipo de tecnologia é muito baixo (principalmente se pensarmos a nível de organizações grandes ou países), característica que deve se tornar ainda mais relevante nos próximos anos.

Você pode imaginar ciborgues no futuro, mas provavelmente as armas autônomas e mortais serão como este pequeno drone

Você pode imaginar ciborgues no futuro, mas provavelmente as armas autônomas e mortais serão como este pequeno drone

É preciso reunir os governantes dos países, os acionistas de empresas bélicas e os cientistas da área em um mesmo local para discutir sobre uma definição de uma lei geral. Já há um esqueleto pautado sobre os outros métodos de guerra, mas falta um preenchimento para regulamentar especificamente a parte de robôs autônomos.

Estamos longe de uma regulamentação?

Em 2014, algumas pessoas da ONU responsável por campanhas de desarmamento sentaram para discutir o assunto, mas nenhum progresso foi feito. Tecnicamente, muitos países assinaram o Protocolo de Genebra, no qual o Artigo 36 diz que “em estudos, testes ou aquisição de novos armamentos, meios ou métodos de guerra, é obrigatório que se saiba se ele seria proibido pelo protocolo desta convenção ou por quaisquer outras leis internacionais aplicáveis para os Estados-membros”.

Infelizmente, a prática não funciona tão bem quanto a teoria, pois este trato não obriga (apesar de dizer no artigo) nenhum dos participantes a, de fato, cumprirem. É necessário apenas demonstrar transparência.

Há um termo estadunidense (o único do mundo), assinado em 2012, que se compromete a não ter nenhum tipo de sistema autônomo capaz de realizar decisões morais e deter responsabilidades pelos próximos 30 anos, necessitando que exista no fim da ponta uma decisão humana. Entretanto, ele é válido exclusivamente para o território dos Estados Unidos.

De acordo com Stuart Russel, é preciso criar uma legislação em até, no máximo, dois anos a partir de agora, pois já estamos atrasados neste assunto.

O que pensar do futuro?

Mesmo em um futuro com proibições, regulamentações e distinções claras sobre o uso de armas autônomas, isso não impede o uso e criação delas. O caso pode ser associado com a utilização de bombas de fragmentação, ataques químicos ou nucleares, que são realizados mesmo com a legislação internacional em vigor por conta da busca por expansão territorial ou interesses políticos.

A discussão sobre os sistemas militares inteligentes já está atrasada em anos, conforme relatado por especialistas da área. Muitos experts, com o engenheiro de robótica Alan Winfield, acreditam que a tecnologia atual, seja para ambientes caseiros ou para locais em guerra, ainda é muito simplista, fraca e longe do que imaginamos quando pensamos no cenário de máquinas dominando o mundo.

"O monopólio das condutas de guerra podem, em breve, ser retirado das mãos humanas"

"O monopólio das condutas de guerra podem, em breve, ser retirado das mãos humanas"

Em contrapartida, há uma interpretação distinta desses fatos. Sistemas que podem executar cidades inteiras apenas com drones do tamanho da palma da mão, podem estar mais perto do que parecem, defende Stuart Russel.

Para regulamentar a fabricação de armas químicas, por exemplo, há um rígido controle e fiscalização sobre companhias que detém o material necessário para produzi-las. Talvez, em um futuro próximo, empresas que fabricam drones comerciais ou contém algum tipo de tecnologia que poderia ser nociva em mãos erradas, tenham de passar pelo mesmo processo rígido.

Qual a sua opinião sobre robôs militares autônomos? Comente no Fórum do TecMundo

De uma forma ou de outra, é evidente que pouco se fala sobre o assunto, apesar de ele já estar batendo na porta. “Se essa tecnologia mortal chegar, e não tivermos um plano para ela, há a possibilidade dela se proliferar rapidamente por conta do baixo custo e alcançar as mãos erradas, como a ISIS”, afirmou Russel.

Fontes

Categorias

![Imagem de: Toshiba apresenta robô que vai limpar o reator de Fukushima [vídeo]](https://tm.ibxk.com.br/2016/01/18/18173103822267.jpg?ims=164x118)

![Imagem de: Veja o trabalho hipnótico desses robôs organizadores de baterias [vídeo]](https://tm.ibxk.com.br/2016/01/12/12165539191483.jpg?ims=164x118)

![Imagem de: Home office: 93 vagas para trabalho remoto internacional [17/04]](https://tm.ibxk.com.br/2024/04/17/17143616272177.jpg?ims=288x165)