Quando a Google eliminou a Facebook da competição e arrematou a empresa de I. A. (inteligência artificial) DeepMind, muita gente se perguntava qual seria o próximo passo — afinal, carros voadores e outras geringonças nos preparam a todos para virtualmente qualquer coisa. As apostas, entretanto, ficou em algum ponto entre o desenvolvimento de novos sistemas de buscas ou de geringonças robóticas. Bem, o resultado são... Jogos do Atari 2600.

Em estudo recentemente publicado na revista Nature, uma equipe de pesquisadores relata as experiências obtidas ao expor a I. A. da DeepMind em contato com 49 jogos de Atari. Ok, nesse ponto, alguém provavelmente pode se questionar: “Mas os computadores já aprenderam jogos anteriormente, não?”. Pois é. Entretanto, isso jamais se deu de forma tão “humana”.

Aprendizado humano

Em vez de ser treinada para encarar cada título especificamente, o software da DeepMind foi capaz de, efetivamente, aprender as regras de cada um deles por meio da descoberta de padrões. “A abordagem mostrou uma adaptabilidade impressionante”, relatou o diretor do Instituto Max Planck para Sistemas Inteligentes, Dr. Bernhard Schölkopf, em texto constante no referido estudo.

De fato, cada um dos sistemas utilizados durante a pesquisa foi instruído para encarar apenas um dos 49 jogos — de maneira que os 48 restantes foram aprendidos por conta, na base da tentativa e erro e no registro de padrões. Trata-se, basicamente, de um padrão estritamente biológico de aprendizado: o DeepMind aprende novos jogos de forma muito semelhante com a que você faria, mesmo que com algumas limitações.

Os pesquisadores acreditam que é justamente essa a mudança de paradigma que pode mudar os rumos da inteligência artificial — pavimentando o caminho para que sistemas do futuro se tornem aptos a lidar com as contingências típicas de um centro urbano apinhado de gente, por exemplo, a fim de dirigir um veículo ou controlar máquinas as mais variadas. É a diferença entre ter um bom computador para jogar xadrez e um que saiba “conviver” e “aprender”.

“Tomados em conjunto, os nossos trabalhos ilustram o poder de juntar o que há de melhor em técnicas de aprendizado de máquinas com mecanismos biologicamente inspirados, a fim de criar agentes que sejam capazes de aprender e de dominar uma ampla variedade de tarefas”, escreveram os autores da pesquisa — os quais esperam tornar suas I. A. semibiológicas capazes de muito mais do que simples jogos do Atari 2600 em um futuro não tão distante.

Reforço positivo

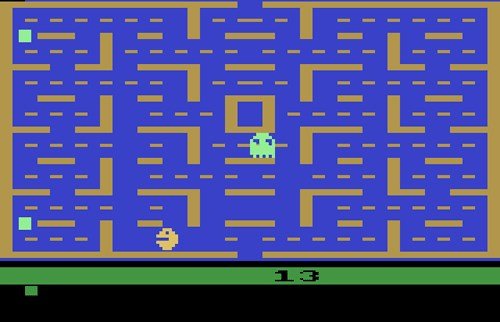

O padrão de funcionamento/aprendizado de que se vale o DeepMind se baseia em algo conhecido como “reforço positivo”. Trata-se da capacidade de empreender tentativas baseadas em sucessos anteriores, sempre em busca de novas recompensas — ou, no caso de um jogo de Atari 2600, de uma “morte” evitada ou de uma pontuação cada vez maior. Abaixo, você confere o DeepMind encarando pela primeira vez o game Breakout.

Conforme é possível observar, embora as primeiras tentativas sejam um tanto desengonçadas, não demora muito para que a I. A. identifique os padrões de erro e acerto. Após algumas centenas de tentativas seguidas, os erros passam a ser cada vez mais raros e, ao final do vídeo, é possível ver que a DeepMind já desenvolveu uma tática específica para “limpar” os cenários de forma mais efetiva e segura — através da formação de “túneis” na parte superior da tela.

Péssimo no Pac-Man

No total, a I. A. da Google se saiu melhor do que algoritmos computacionais anteriores em 43 dos 49 títulos. No caso da comparação com seres humanos, entretanto, o software levou a melhor em apenas 29 jogos. Em alguns títulos, entretanto, o DeepMind apresentou resultados simplesmente pífios, revelando uma inépcia considerável em relação à capacidade de retenção de informações ao longo do tempo.

“O clássico Ms. Pac-Man ilustrou claramente a maior limitação do software: ele é incapaz de fazer planos para mais do que alguns segundos à frente”, atestou Tom Simonite, do MIT Technology Review. “Isso impede que o sistema descubra como atravessar o labirinto de forma segura, a fim de comer as pastilhas restantes e completar a fase. Ele também foi incapaz de perceber que a ingestão das pílulas especiais permitia comer os mesmos fantasmas que, na maior parte das vezes, precisava fugir a todo custo.”

Menos de um segundo de memória

Para Simonite, os algoritmos atuais do DeepMind deixam o programa atado ao presente. “Ele apenas olha para os últimos quatro frames do jogo (a décima quinta parte de um segundo) para aprender quais são os movimentos com os melhores resultados, ou para definir como a experiência anterior pode ser utilizada para ditar os próximos movimentos.” Em outras palavras, o DeepMind, até o momento, sabe lidar apenas com táticas de recompensa imediata.

Naturalmente, versões futuras do DeepMind devem ganhar quantidades maiores de memória, a fim de poder traçar estratégias de longo prazo. Será o momento, ao que parece, em que os carros finalmente vão poder se tornar autônomos — e em que os tradutores finalmente poderão emitir sentenças que não pareçam informações fragmentadas.

Fontes